允中 发自 凹非寺

量子位 | 公众号 QbitAI

在开源社区中把GPT-4+Dall·E 3能⼒整合起来的模型该有多强?

香港中文大学终身教授贾佳亚团队提出多模态模型Mini-Gemini:

更高清图像的精确理解、更高质量的训练数据、更强的图像解析推理能力,还能结合图像推理和生成,堪称王炸。

Mini-Gemini还提供了2B小杯到34B的超大杯,最强模型在多个指标上相比谷歌的Gemini Pro甚至GPT-4V都不遑多让。

目前,Mini-Gemini从代码、模型到数据已全部开源,登上了PaperWithCode热榜。

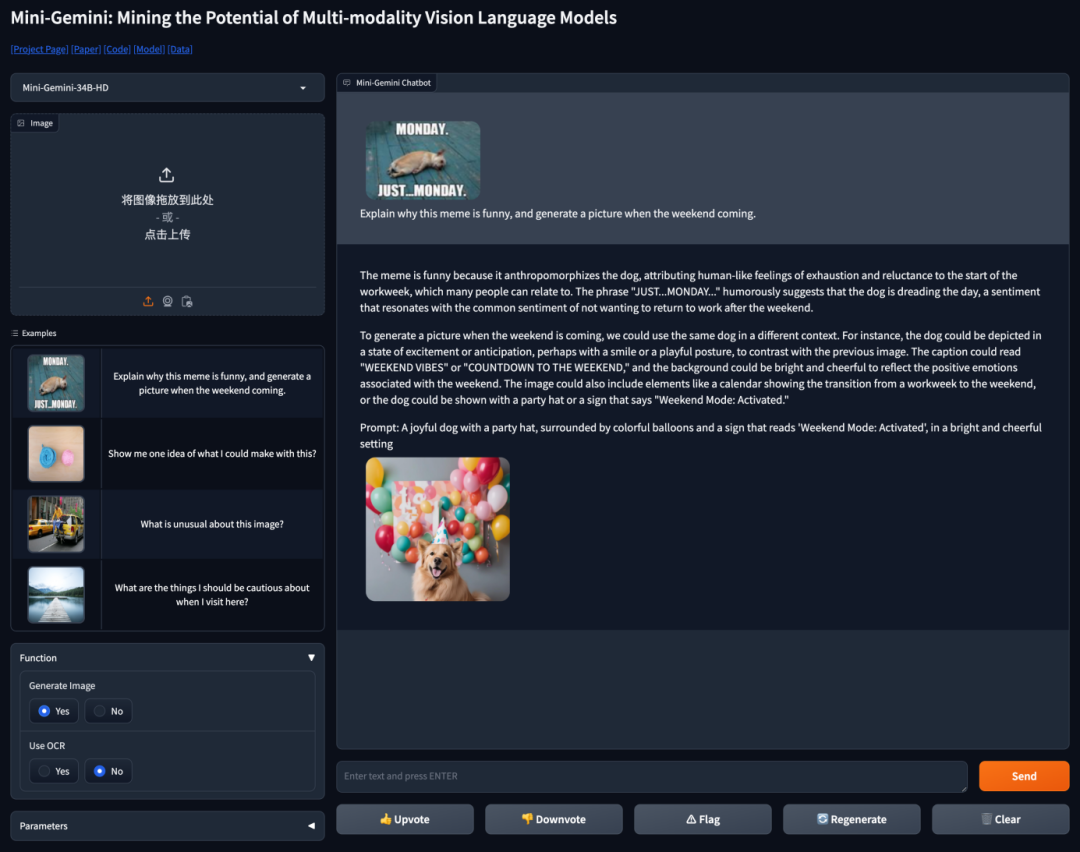

Mini-Gemini线上Demo也已发布,超会玩梗,一起来体验下!

接近商业闭源模型水平

Mini-Gemini Demo放出后受到广大网友关注,一番“品尝”后,他们认为Mini-Gemini跟商业模型差不了多少。

目前,绝大多数多模态模型仅支持低分辨率图像输入和文字输出,而在实际场景中,许多任务都需要对高清图像进行解析,并用图像的形式进行展现。

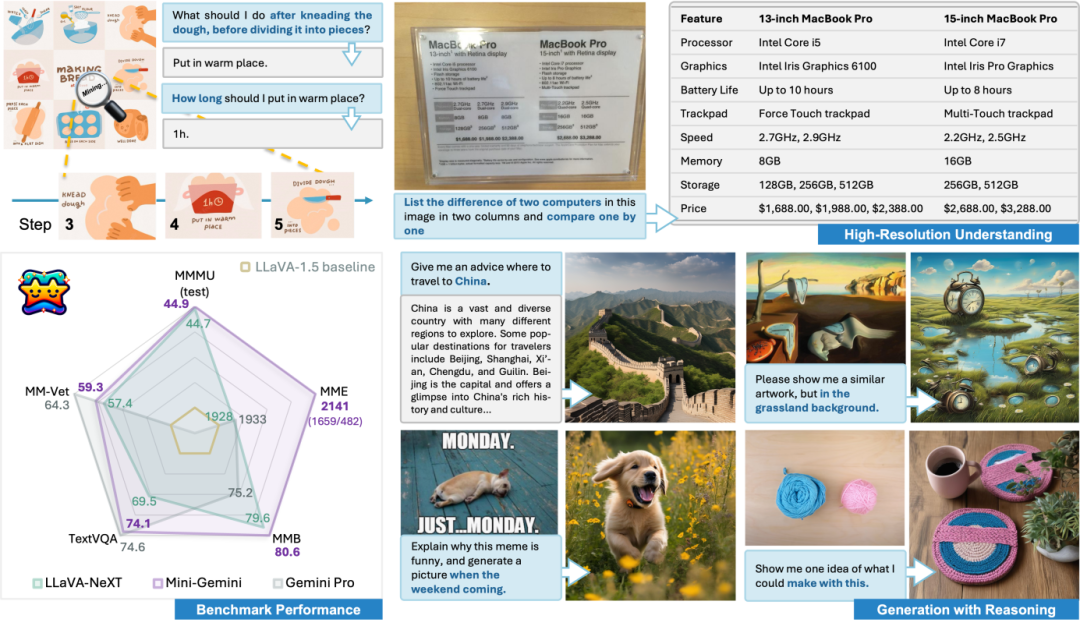

如下图所示,Mini-Gemini不仅能够根据图片对做面包的过程进行手把手教学,也能够准确将不同电脑品种根据图片中的各种参数进行对比。

有网友开玩笑说,这下妈妈不用担心我独自生活了。

更重要的是,Mini-Gemini在保留超强的图像理解和推理能力的同时,还解锁了图像的生成能力,就如同ChatGPT和生成模型的结合。

下面,让我们通过几个例子来更直观地感受这种能力:

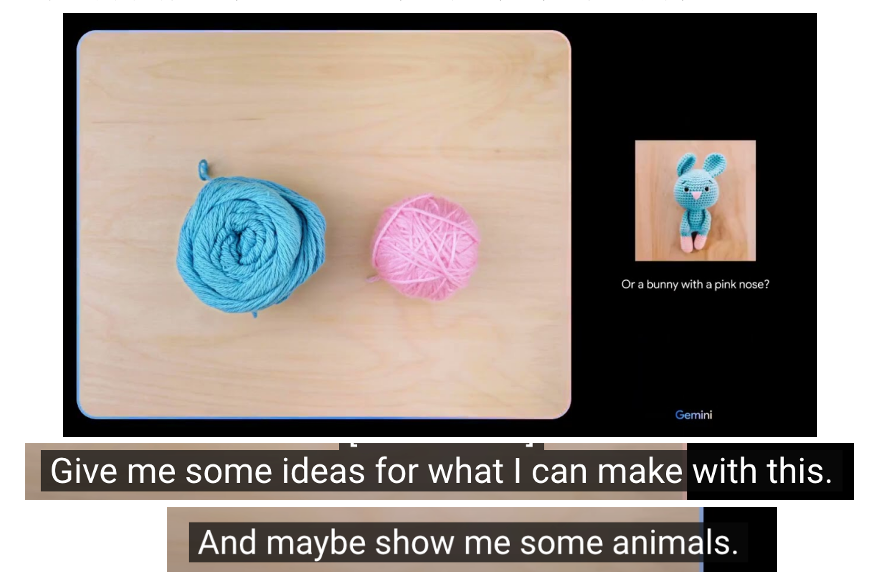

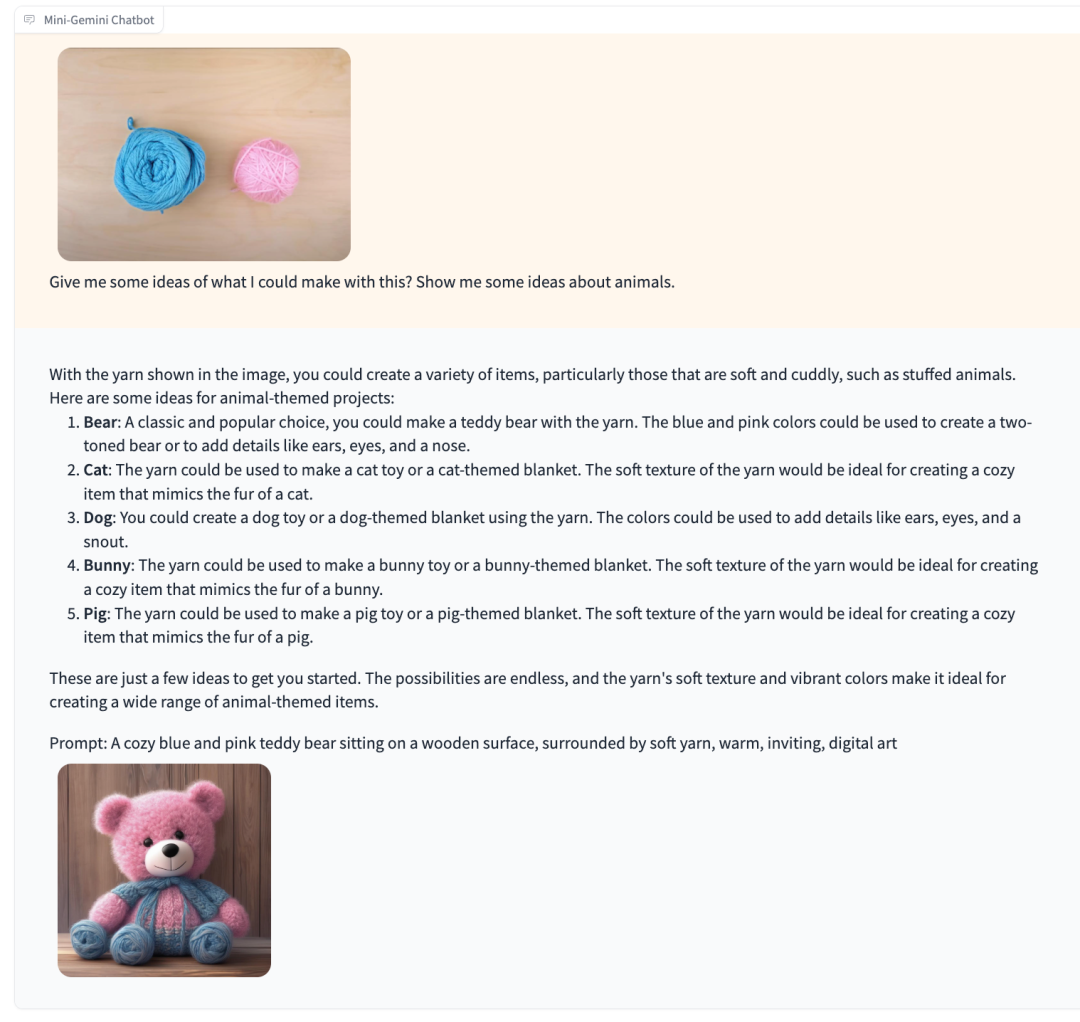

还记得Google Gemini的官方演示视频么?当用户给出两个毛线团并问出能用它们做什么时,Gemini可以识别出图片内容并给出相应的建议。

当我们把相似的输入给到Mini-Gemini,它会怎么回答呢?

可以发现,Mini-Gemini也可以识别出图片中的元素,并且合理地建议,同时生成了一只对应的毛线小熊。

通过一些抽象的多模态指令来让模型给出推理,并生成合适的图片,这个操作就很像是ChatGPT和DALL·E 3的联动了。

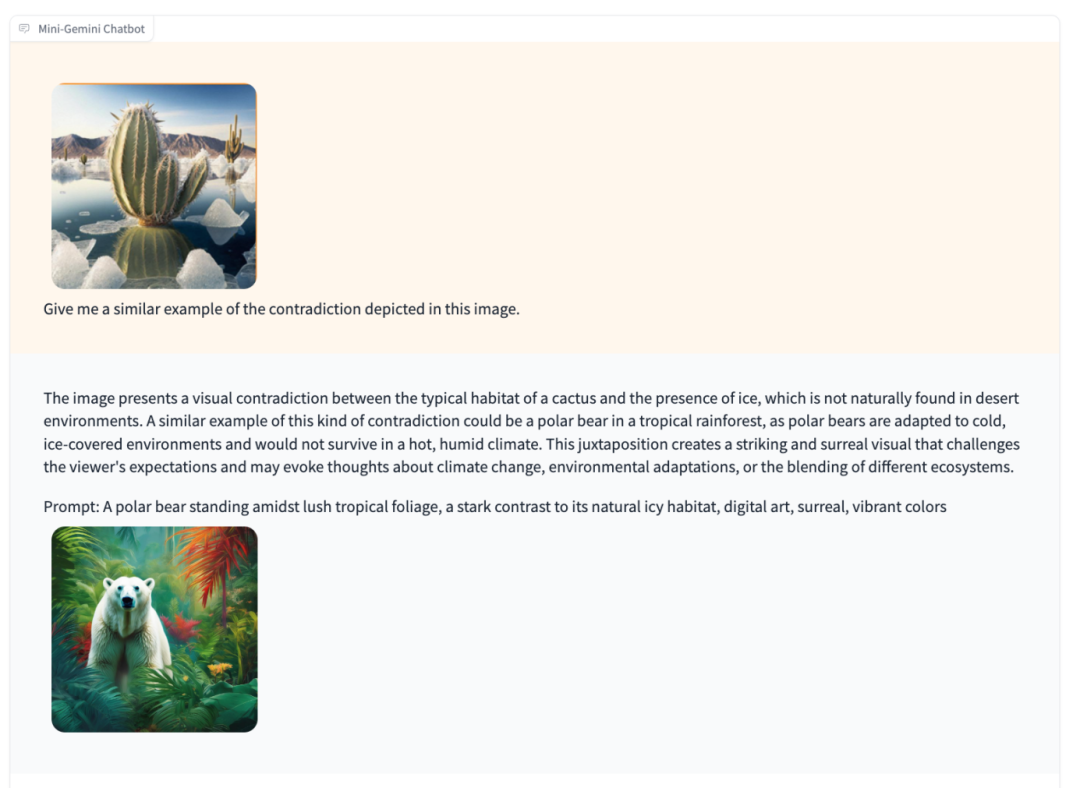

接下来让Mini-Gemini做自己最擅长的推理和图片理解,看看它表现:

比如理解图片中的矛盾点并举一反三——输入冰川中的仙人掌,它会解释其中的矛盾并生成一张热带雨林中北极熊的图片:

图片呈现了仙人掌的典型栖息地与冰的存在之间的视觉矛盾,因为在沙漠环境中自然不会出现冰。这种矛盾的类似例子可能是一只北极熊出现在热带雨林中,因为北极熊适应于寒冷、覆盖着冰的环境,在炎热潮湿的气候中无法生存。这种并置创造了一个引人注目且超现实的视觉效果,挑战观众的期待,并可能引发人们对气候变化、环境适应或不同生态系统融合的思考。

同时,正如ChatGPT+DALL·E 3的梦幻结合一样,Mini-Gemini的“推理生成”功能还可以在多轮对话中通过简单指令生成连环小故事。

比方说,让它根据用户输入讲一个贵族小老鼠的故事,Mini-Gemini会根据前文的文字生成结果和用户输入进行推理,在保持一致性的情况下对图片进行修改,使其更符合用户的要求。

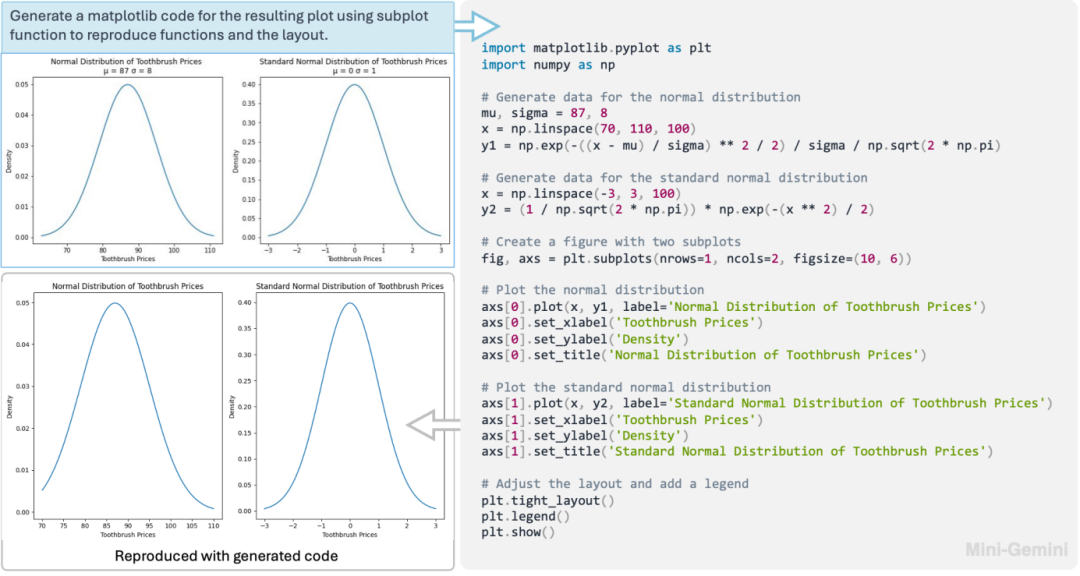

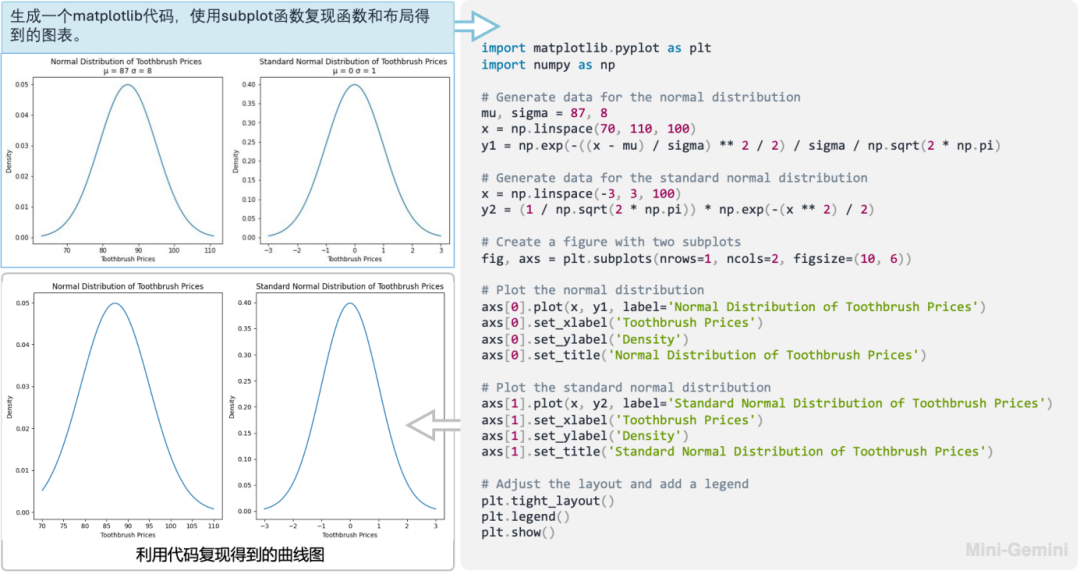

当然,Mini-Gemini对于多模态模型的传统技能图表理解也不在话下。比方让模型理解输入曲线图的数学意义(高斯分布),并让它使用代码复现这张图,通过运行生成的代码,模型可以高质量地还原曲线图,节省了复现的时间。

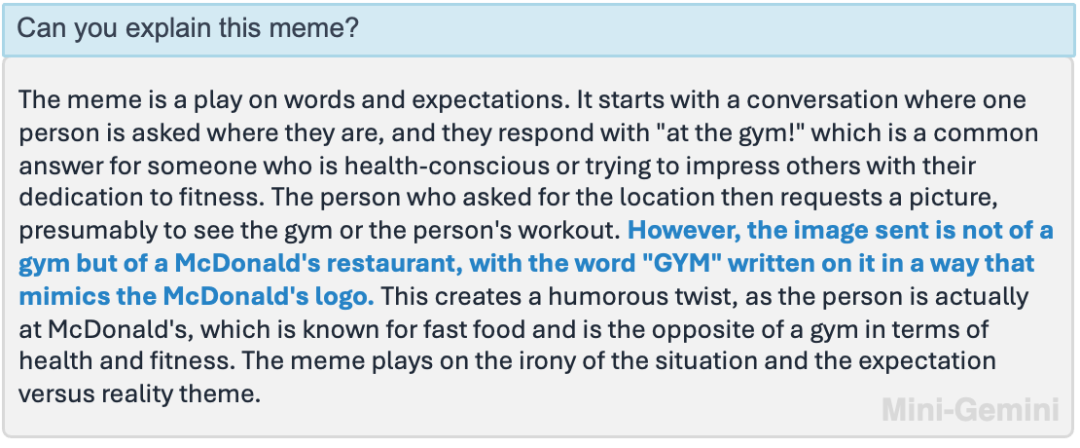

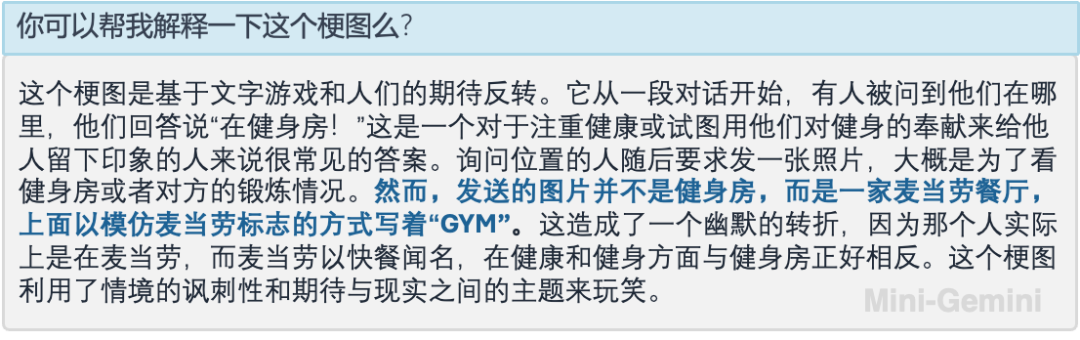

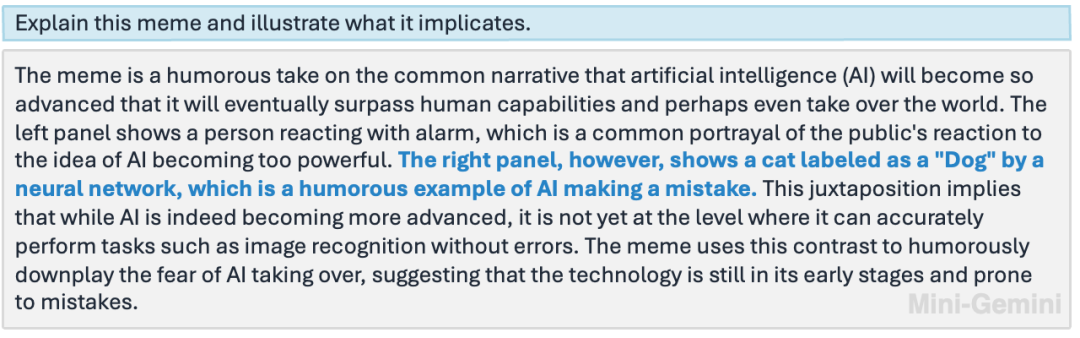

又或者让Mini-Gemini理解梗图,通过其强大的OCR和推理能力,也可以准确指出笑点。

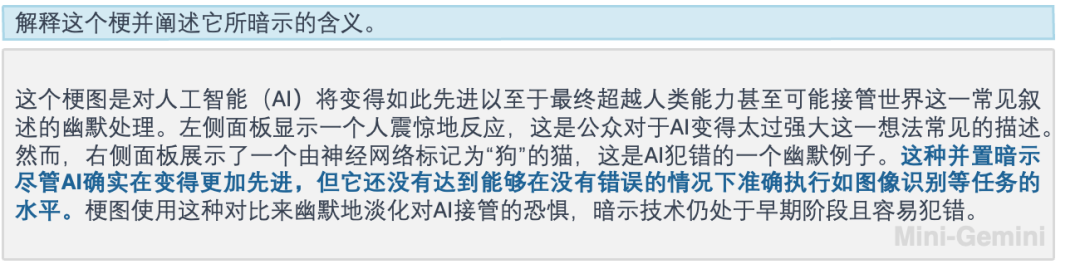

在另一个案例中,Mini-Gemini除了理解梗图本身,甚至推测了制作者的深层意图。

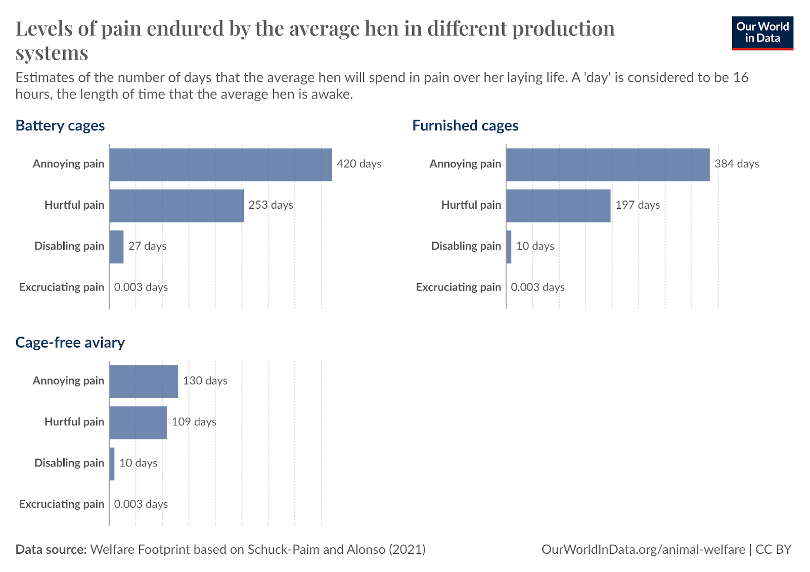

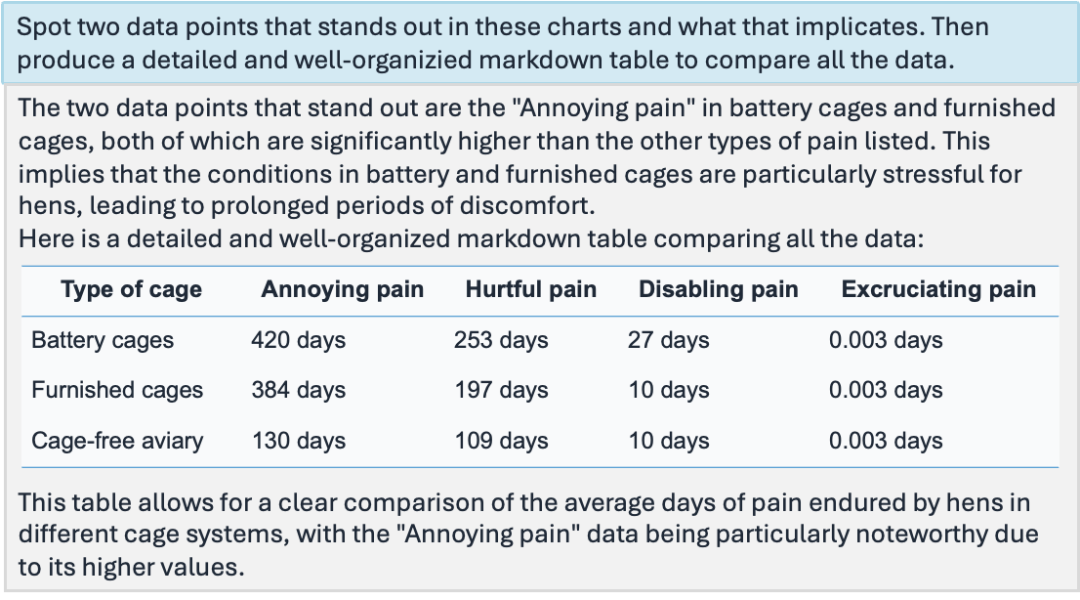

高清复杂的多图表理解和归纳也是小菜一碟,Mini-Gemini直接秒变打工人效率提升的超级外挂。

技术细节:

那么问题来了,Mini-Gemini是怎样做到这种惊艳的效果呢?

核心在于三点:

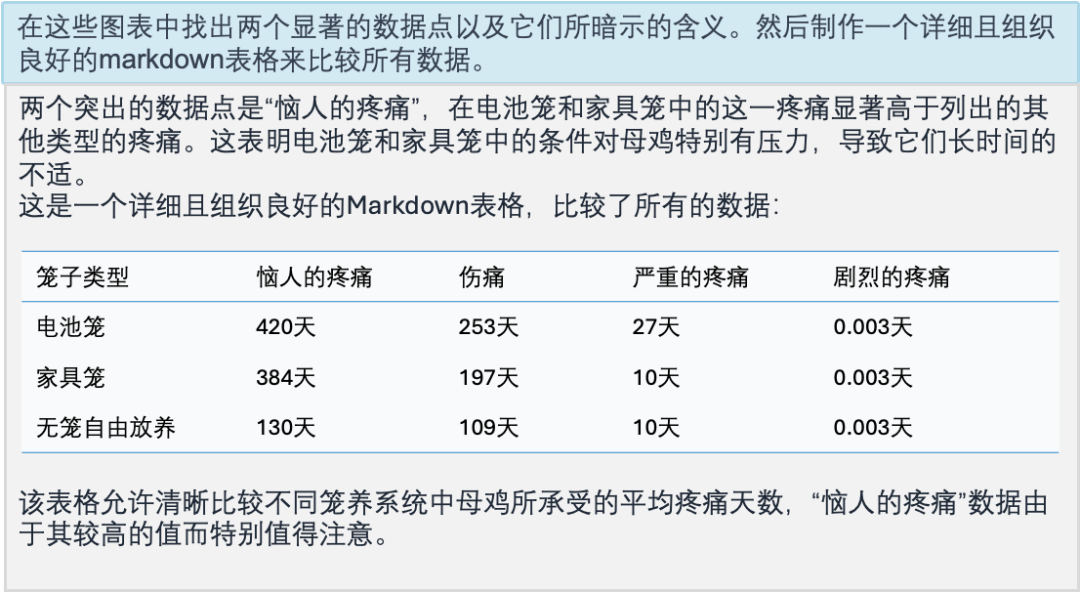

(1) 用于高清图像的双编码器机制

(2) 更高质量的数据

(3) 训练阶段结合生成模型数据拓展

大道至简,Mini-Gemini的整体思路并不复杂。其中的Gemini(双子座)表达的是使用视觉双分支的信息挖掘(Mining-Info in Gemini)解决高清图像理解问题。

详细来说,Mini-Gemini将传统所使用的ViT当做低分辨率的Query,而使用卷积网络(ConvNet)将高分辨率的图像编码成Key和Value。

使用Transformer中常用的Attention机制,来挖掘每个低分辨率Query所对应的高分辨率区域。从而在保持最终视觉Token数目不变的情况下去提升对高清图像的响应,保证了在大语言模型(LLM)中对于高清图像的高效编码。

值得一提的是,由于高分辨率分支卷积网络的使用,可以根据需要对图像所需的分辨率自适应调整。对于图像的生成部分,Mini-Gemini借助了SDXL,使用LLM推理后所生成的文本链接两个模型,类似于DALL·E 3的流程。

对于数据,Mini-Gemini进一步收集并优化了训练数据的质量,并加入了跟生成模型结合的文本数据进行训练。在仅使用2-3M数据的情况下,实现了对图像理解、推理和生成的统一流程。

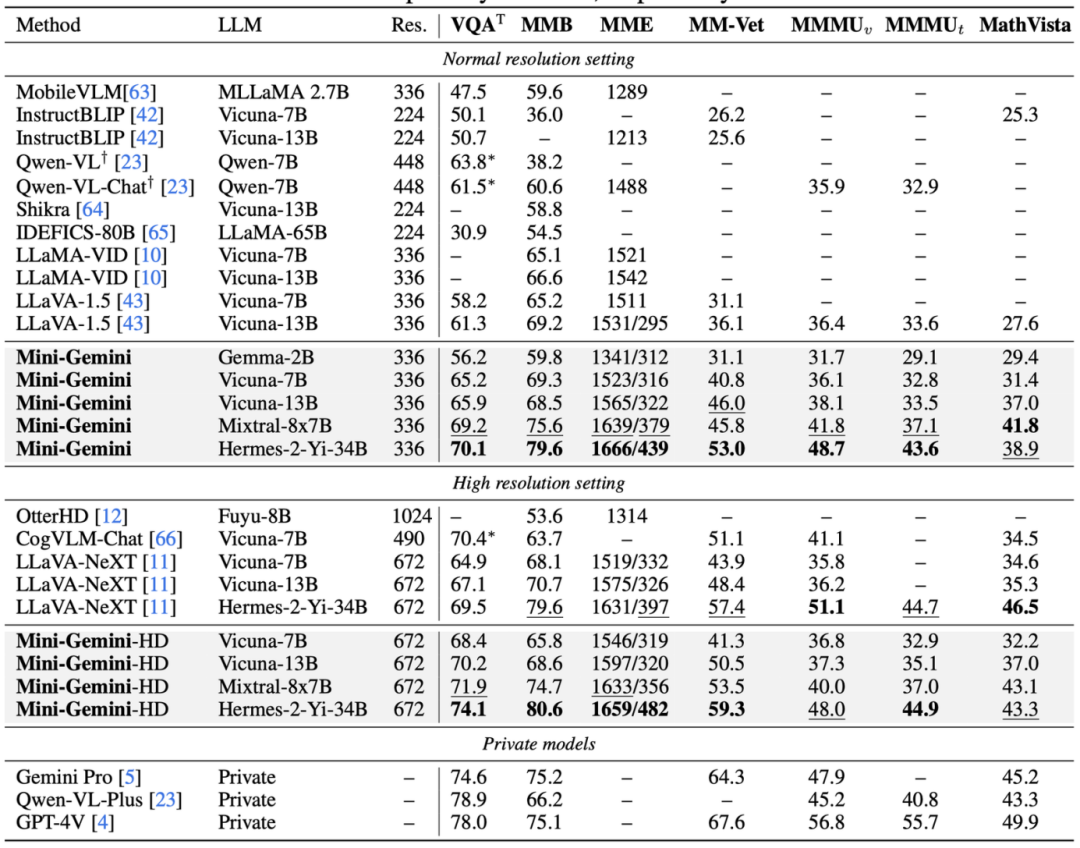

Mini-Gemini在各种Zero-shot的榜单上毫不逊色于各种大厂用大量数据训练出来的模型。

量化指标:

可以看出,Mini-Gemini提供了多种普通和高清版本的模型,并且覆盖了2B的小杯到34B的超大杯,各个版本都取得了相似参数量下领先的效果,在许多指标上甚至超越Gemini Pro和GPT-4V。

在线可玩:

值得一提的是,Mini-Gemini的图像理解和生成能力已经出了Demo,可以在线跟自定义图像对话的那种。

操作也极其简单,直接跟输入图像或文字进行对话即可,欢迎来撩!

Github地址:https://github.com/dvlab-research/MiniGemini

Demo地址:http://103.170.5.190:7860/

论文地址:https://arxiv.org/pdf/2403.18814.pdf

模型地址:https://huggingface.co/collections/YanweiLi/mini-gemini-6603c50b9b43d044171d0854

数据地址:https://huggingface.co/collections/YanweiLi/mini-gemini-data-660463ea895a01d8f367624e

*本文系量子位获授权刊载,观点仅为作者所有。

— 完 —

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见 ~